간단한 심부름부터 국가정책 입안까지 만능해결사

오작동이나 판단 실수 같은 윤리문제 현실화될 것

공론화, 토론 등을 통해 인간이 답을 내릴 수밖에

[일요주간=노현주 기자] 기업 운영진과 컨설턴트, 학자군들 모두 인공지능(AI)을 비즈니스 및 IT 운영부터 고객 서비스까지 모든 것을 일대 혁신하는 경이적 기술이라고 칭송한다. 많은 전문가들은 머지않아 제조, 금융, 의료 등 다양한 사업 분야를 아울러 AI 기술이 적용되어 사회 전반에 광범위한 영향을 미칠 것이라 내다보고 있다.

● 인간 통제를 벗어날 가능성 점증

미래에 인공지능의 보급되면 간단한 심부름부터 국가정책 계획을 하는 것까지 삶의 곳곳에 AI를 사용할 것이다. 그러나 도덕 개념이 없는 인공지능은 명령에 따라 움직이기 때문에 인류에게 매우 위협적인 존재로 돌변할 수 있다. AI 기술의 그림자에도 주목해야 한다는 목소리가 높아지고 있는 것이다.

세계의 석학들과 전문가들은 AI가 인간 통제 범위를 벗어날 가능성이 점증하면서 인류에게 큰 위협이 될 것을 경고하고 나섰다.

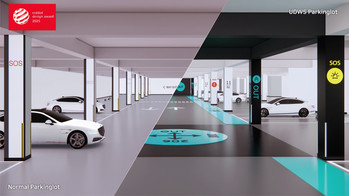

| ▲인류와 AI는 공존할 수 있을까? 인간이 AI를 통제할 수 있는지에 대한 윤리 논쟁이 치열하다.ⓒPixabay |

최근 들어 AI에 대한 관심이 크게 높아진 가운데 AI 윤리 문제가 현실화할 것으로 전망되고 있다. 이런 윤리적 문제는 AI 통제론 논쟁을 불러일으키고 있는 것이다. 인간을 위해 만든 AI 비서, 로봇, 자율주행차, 로봇어드바이저, 살상무기 등은 오작동이나 판단 실수 같은 문제를 일으킬 수 있기 때문이다.

더욱이 인간이 AI를 통제할 수 있는지에 대한 윤리 논쟁도 치열하다. AI가 자유의지를 가지고 있다고 믿는다면 통제가 어렵다. 가령 부모는 자녀를 통제하기가 쉽지 않다고 느끼는 경우가 많을 것이다.

이에 AI 관련 윤리 연구가 큰 주목을 받는다. 2016년 12월 미국 과학기술 비영리단체 국제전기·전자기술자협회(IEEE)는 AI가 가져올 부작용을 막고자 개발자를 대상으로 ‘윤리를 고려한 설계(Ethically Aligned Design)’를 배포했다.

2017년 1월 유럽연합(EU)은 ‘전자인간법’을 제정했다. 핵심 요지는 AI에 법적인 지위를 보장하는 동시에 AI로부터 빚어질 위협을 미연에 방지하자는 것이다.

● ‘살상무기와 해킹’ 가능성 매우 높아

윤리학자들이 가장 우려하는 AI 분야는 자율살상무기(LAWS·Lethal Autonomous Weapons Systems)다. 최근 유엔의 특정재래식무기금지협약(CCW)에서 이 문제를 의제로 다루기 시작했다. 급속도로 발전하고 있는 AI 기술로 자율살상 로봇 생산 가능성이 높아지면서 논란은 심화하고 있다.

|

| ▲AI 관련 윤리 연구가 큰 주목을 받는다. 2016년 12월 미국 과학기술 비영리단체 국제전기·전자기술자협회(IEEE)는 AI가 가져올 부작용을 막고자 개발자를 대상으로 ‘윤리를 고려한 설계(Ethically Aligned Design)’를 배포했다.ⓒPixabay |

살상 로봇은 각종 행동지침이 프로그램 되어 있다고 하더라도 실제 교전 중에 벌어지는 다양한 상황에 대처하기 힘들다. 또한 킬러 로봇이 대량학살 등 전쟁 범죄를 저지른 경우, 소송의 대상이 불명확하기 때문에 법적 책임을 부여하는 것도 쉽지 않다.

이 인공지능의 도덕성 문제를 해결하기 위해서는 세계 모든 국가들이 절대로 군사작전엔 인공지능을 투입하지 말자는 협약을 맺어야 한다. 인간의 생명이 직접적으로 관련 되는 일에는 인공지능 로봇을 사용 금지하는 법안을 만들어야 한다.

최근 미국 캘리포니아 주 아실로마에서는 AI 전문가들이 모여 회의를 열고 살상 가능한 자율적 무기를 개발하기 위한 경쟁은 지양해야 한다는 내용이 포함된 23개 조항의 ‘아실로마 AI 원칙’을 만들었다.

또 AI의 발전에서 가장 우려되는 것 중의 하나는 해킹의 우려이다. 캠브리지와 옥스퍼드, 예일대학의 기술 및 공공 정책 분야 연구원이 발표한 보고서에 따르면, AI가 빠른 속도로 발전하면서 가까운 장래에 악의적인 의도를 가진 사용자가 자동화 된 해킹 공격에 나설 가능성이 높다는 것이다. AI가 해킹되면 사람을 가장한 가짜 정보 유포 및 확산에 충분히 악용할 수 있다.

|

▲AI가 빠른 속도로 발전하면서 해킹 등 사이버 범죄에 대한 우려가 커지고 있다.ⓒPixabay |

인공지능 윤리는 오랫동안 구체적인 수준에까지 논의가 되어야 할 주제이다. 인공지능은 결국 인류와의 공존까지 고려되기 때문에 이해관계자는 전 인류가 대상이 될 수밖에 없다.

인공지능이 무슨 일을 하고 있는지 제작과정서부터 투명성을 유지해야 하며 인공지능 발전 과정에서 잘못된 오용을 방지하기 위해 국가, 혹은 사회적으로 인식을 공유할 수 있는 장치가 마련돼야 한다.

사람의 일을 돕기만 하던 인공지능 기술이 발전함에 따라 4차 산업혁명 시대에 발생할 수 있는 윤리적 문제에 대해서는 공론화, 토론 등을 통해 인간이 답을 내릴 수밖에 없다. 그동안 많은 사람들이 인공지능에 대해 크고 작은 두려움을 느껴왔다. 명료한 윤리지침을 통해 예견되는 두려움을 극복해야 AI 발전을 도모할 수 있을 것이다.

'시민과 공감하는 언론 일요주간에 제보하시면 뉴스가 됩니다'

▷ [전화] 02–862-1888

▷ [메일] ilyoweekly@daum.net

[저작권자ⓒ 일요주간. 무단전재-재배포 금지]

![부산 덕포동 중흥S클래스 건설현장서 화재 발생...검은 연기 치솟아 [제보+]](/news/data/20220901/p1065590204664849_658_h2.jpg)

![[포토] 제주 명품 숲 사려니숲길을 걷다 '한남시험림'을 만나다](/news/data/20210513/p1065575024678056_366_h2.png)

![[포토] 해양서고 예방·구조 위해 '국민드론수색대'가 떴다!](/news/data/20210419/p1065572359886222_823_h2.jpg)

![[언택트 전시회] 사진과 회화의 경계](/news/data/20210302/p1065575509498471_939_h2.jpg)